Il mio discorso di fine anno (notate il look ispirato a...).

L’economia esiste perché esiste lo scambio, ogni scambio presuppone l’esistenza di due parti, con interessi contrapposti: l’acquirente vuole spendere di meno, il venditore vuole guadagnare di più. Molte analisi dimenticano questo dato essenziale. Per contribuire a una lettura più equilibrata della realtà abbiamo aperto questo blog, ispirato al noto pensiero di Pippo: “è strano come una discesa vista dal basso somigli a una salita”. Una verità semplice, ma dalle applicazioni non banali...

mercoledì 31 dicembre 2014

La säga dell’Äni

Sarà una lunga storia.

Le condizioni climatiche le sapete.

Ieri sera stavo cucinando per i bambini, si spengono i fornelli.

Provo ad accenderli, uno sbuffo di gas, poi il niente. La caldaia comincia a fare un rumore strano. La spengo.

Le condizioni climatiche le sapete.

Ieri sera stavo cucinando per i bambini, si spengono i fornelli.

Provo ad accenderli, uno sbuffo di gas, poi il niente. La caldaia comincia a fare un rumore strano. La spengo.

Chiamo l'Äni, e qui comincia la parte divertente (tranquilli, non morirò di fame e ho inverter in tutte le stanze).

Il primo operatore, chiamato alle 20. Dopo mezz'ora di musichetta interloquisce. Io avevo l'ultima fattura (pagata), pensando che sarebbe bastato il numero cliente. Risposta: "Il servizio guasti non condivide i dati col servizio commerciale". Ecco: quindi se avete un guasto, ma non siete clienti Äni, chiamate anche l'Äni, che magari nel dubbio arriva. Passo così un quarto d'ora a parlare del mio argomento preferito: me. Ma apprendo una cosa importante: per l'Äni noi non siamo solo un numero. L'operatore infatti entra in loop come una routine basic scritta male quando gli segnalo che sul citofono non c'è il mio nome, ma un numero. Questa cosa fatica un po' a comprenderla: "E allora come faccio a trovarla?". Gli faccio capire che esiste una corrispondenza biunivoca fra il mio appartamento e il numero sul citofono. Passando per Cauchy riesco a convincerlo. Provo a dirgli: "ma eventualmente potete telefonarmi, e scendo ad aprire il locale dei contatori". Risposta: "Noi non abbiamo questo dato". Io penso: "Cazzo, mi hai chiesto se ho avuto malattie importanti, non vuoi chiedermi il numero di telefono? Guarda che te lo do". Ma ovviamente, stanti le difficoltà già incontrate, rinuncio.

Mi dice di chiudere contatore e valvola dell'appartamento, e che passerebbero in serata.

Eseguo.

Mi stendo e crollo dal sonno. Alle 21 mi risveglio bestemmiando, pensando che devo aspettare i solerti addetti.

Alle 22 torna Rockapasso, delego e provo ad addormentarmi, ma ovviamente niente. Lei si pone il problema: ma questi quando arrivano? Mica arriveranno all''una.

Richiama. Altro "ticket": come ti chiami, quanti anni hai, cosa vuoi fare da grande...

Alla fine il responso: al massimo entro le 24, e comunque telefoniamo. Lei: "Ma se il numero non ce l'a..." "Tuu, tuu, tuu...".

Almeno dormiamo.

Questa mattina, caffè dalla suocera (sempre sia lodata), dopo di che richiamo. Almeno questa volta la voce era partenopea, anziché padana: già un progresso, o una correlazione, fate voi.

Stessa storia: nome, cognome, via, quartiere... (pure il quartiere: credo che il consumo mondiale di lignite sia sostenuto dagli elaboratori elettronici dell'Äni!).

Allora je dico: "No, sa, siccome avevate detto che passavate ieri, mi stavo preoccupando per voi, volevo sapere se avevate avuto un problema, magari qualcuno s'è inteso male, o io non v'ho sentito". Lui fa: "No, guardi, è che ci pensa il servizio tecnico di Roma, e comunque quando arrivano la chiamano al XXX YYYYYYY".

Il numero che il servizio guasti non aveva, perché non incrocia i dati col servizio clienti.

Dal che si evince:

1) che l'Äni è una banda di cazzari (e questo si sapeva: basti pensare che il suo difensore d'ufficio è il direttore del PUDE24Ore);

2) che i napoletani sono più efficienti dei padani;

3) che la colpa è di Alemanno (se siete di sinistra) o di Marino (se siete di destra), visto che quelli che devono intervenire sono dei romani.

Vi terrò al corrente dei piacevoli sviluppi. Se incontrate l'Äni, salutatemela...

martedì 30 dicembre 2014

L'ipercorrettivismo è la malattia senile dell'analfabetismo

Questo post ha diversi sottotitoli:

Non omnes possumus omnia

Qui bene amat bene castigat

Colpirne uno per educarne un altro (rectius: un'altro)

Meglio perdere un amico (de che?) che una buona risposta

Enunciato il sottotitolame, entriamo in argomento. Ricevo da un sedicente matematico questa sconclusionata missiva:

-------- Messaggio Inoltrato --------

Bene, bene, bene, bene...

Ora: io sono un abisso di misericordia (Barmherzigkeit), un oceano di comprensione, una perenne scaturigine di umanità, e una insospettabile riserva di pazienza, ma se c'è una cosa che mi fa girare veramente le sfere sono gli ipercorrettivismi. L'ipercorrettivismo eccita la parte peggiore di me (cioè la migliore, quella che se lasciata libera di perseguire i propri obiettivi renderebbe in un paio di mesi il mondo un posto vivibile) perché si basa su un colossale equivoco. Normalmente l'ipercorrettivista è una persona che pensa di essere un mio simile, non nel senso di avere due (o tre, nel caso dei maschietti) gambe e una testa a separare le orecchie, ma nel senso di essere una persona "colta".

I miei cosiddetti simili: quanta saggezza in queste parole di Gadda.

Dove risiede qui l'ipercorrettivismo (malattia senile dell'analfabetismo: sintomi, una piddina sapienza di sapere una cosa della quale non si sa un cazzo, cioè la lingua italiana)? Risiede nel fatto che io (come il 99% degli statistici ed econometrici italiani) chiamo intervallo di confidenza il confidence interval. Siccome "confidenza" significa anche "rivelazione di un segreto, di una notizia riservata", ma anche "familiarità, dimestichezza", una persona dal campo semantico sufficientemente ristretto potrebbe evidentemente considerare come maccheronica questa traduzione. Certo, sappiamo,

NOI

che confidenza ha anche questo significato. È il significato che assume in spagnolo nella nota espressione "donde hay confianza da asco", o anche "donde hay confianza hay mierda", a significare i pericoli insiti nell'accordare eccessiva confidenza a soggetti appartenenti a settori disciplinari diversi dal tuo (ma anche uguali al tuo).

Secondo l'amico (appunto), la traduzione corretta sarebbe un mai sentito "intervallo di fiducia". Io ho provato a cavarmela scherzandoci sopra (era il colpo d'avvertimento), e ricordando che "la fiducia si dà alle cose serie", e un segmento non è una caciotta.

Niente, ha insistito.

E allora selettore a raffica...

Dunque:

pur rispettando la Magna Grecia e i suoi derivati (come del resto la Lapponia o la Casamance) non accetto lezioni di italiano da chiunque non sia nato all'interno del quadrilatero di coordinate 43.789594, 11.228359; 43.787239, 11.284664; 43.759224, 11.241202; 43.759286, 11.266007 (e mi son tenuto largo),

il soggetto in questione proviene da un ambiente svantaggiato ed è finito in un ambiente svantaggiatissimo (vedi areale stepposo, non do le coordinate), il che costituisce attenuante specifica

"confidenza" del Dizionario Devoto-Oli e "confidenze" del Dizionario Sansoni, che si riportano in allegato al dispositivo della sentenza, questo organo monocratico

clicca e ascolta bene.

"Intervallo di confidenza" è una traduzione perfettamente legittima di "confidence interval" (a meno che tu non voglia insegnare l'italiano a De Finetti, perché con me ti dice male), atteso che la prima traduzione di confidence nel senso di trust, reliance è appunto "confidenza" (e l'intervallo di confidenza a cosa serve, se non a valutare la reliability di una previsione, o, come nel post precedente, la sua totale infondatezza), e che il terzo significato di confidenza è appunto fiducia (che copre un campo semantico lievemente diverso).

Ora, vedi, io non vorrei dirtelo, ma mentre le anaconde e le malgame non esistono (esistono gli anaconda e gli amalgama, però: i primi non li ho mai incontrati, tu hai forse incontrato i secondi), mentre una decade non è un decennio (ma va?), mentre seminale in italiano è una cosa liquida, non una cosa avanzata (nel senso di pionieristica, perché in effetti anche cose seminali possono avanzare, anche se poi si seccano, come mi sto seccando io, ma in un modo diverso), d'altro canto "intervallo di confidenza" si può dire, è una traduzione assolutamente corretta.

Torno a ripeterlo, serenamente, laicamente: non è colpa mia se non siete nati all'interno delle quattro coordinate di cui sopra; non è colpa mia se avete passato la vita a leggere le traduzioni dei romanzi sbagliati. Fosse anche una colpa, io non vi giudicherei per questo. Chi sono io per giudicare? Sapete, nel Vecchio Testamento ci sono tante cose, e c'è anche una versione universalmente nota della morale della favola: il Salmo 129, che qui vi propongo in una delle sue versioni più convincenti: So du willst, Herr, Suende su rechnen... (e solo chi c'è stato dentro sa cos'è).

Però, per favore: abbiamo già avuto un vivaista commissario dell'ANVUR. Risparmiamoci il matematico Accademico della Crusca.

Bene.

Seguono gli allegati, e tranquillo: ti è andata bene.

Allegati

(ah, ovviamente il post vale per te, ma vale anche per l'altro. Lui sa chi è...)

(se non basta, ce n'è ancora...)

("qui è la mia volontà contro la vostra e voi avete già perso. Quando sembrerete degli economisti, comincerete a pensare da economisti". Basta avere gli strumenti didattici appropriati... Ah, naturalmente gli Stati Uniti non sono nazionalisti, Clint sta esagerando...)

Non omnes possumus omnia

Qui bene amat bene castigat

Colpirne uno per educarne un altro (rectius: un'altro)

Meglio perdere un amico (de che?) che una buona risposta

Enunciato il sottotitolame, entriamo in argomento. Ricevo da un sedicente matematico questa sconclusionata missiva:

-------- Messaggio Inoltrato --------

| Oggetto: | Se insisti ... |

|---|---|

| Data: | Tue, 30 Dec 2014 11:45:06 +0100 |

| Mittente: | Marco Basilisco |

| A: | bagnai@unich.it |

... con intervallo di confidenza dirò decade ogni volta che mi pare.E triviale per dire banale!

Bene, bene, bene, bene...

Ora: io sono un abisso di misericordia (Barmherzigkeit), un oceano di comprensione, una perenne scaturigine di umanità, e una insospettabile riserva di pazienza, ma se c'è una cosa che mi fa girare veramente le sfere sono gli ipercorrettivismi. L'ipercorrettivismo eccita la parte peggiore di me (cioè la migliore, quella che se lasciata libera di perseguire i propri obiettivi renderebbe in un paio di mesi il mondo un posto vivibile) perché si basa su un colossale equivoco. Normalmente l'ipercorrettivista è una persona che pensa di essere un mio simile, non nel senso di avere due (o tre, nel caso dei maschietti) gambe e una testa a separare le orecchie, ma nel senso di essere una persona "colta".

I miei cosiddetti simili: quanta saggezza in queste parole di Gadda.

Dove risiede qui l'ipercorrettivismo (malattia senile dell'analfabetismo: sintomi, una piddina sapienza di sapere una cosa della quale non si sa un cazzo, cioè la lingua italiana)? Risiede nel fatto che io (come il 99% degli statistici ed econometrici italiani) chiamo intervallo di confidenza il confidence interval. Siccome "confidenza" significa anche "rivelazione di un segreto, di una notizia riservata", ma anche "familiarità, dimestichezza", una persona dal campo semantico sufficientemente ristretto potrebbe evidentemente considerare come maccheronica questa traduzione. Certo, sappiamo,

NOI

che confidenza ha anche questo significato. È il significato che assume in spagnolo nella nota espressione "donde hay confianza da asco", o anche "donde hay confianza hay mierda", a significare i pericoli insiti nell'accordare eccessiva confidenza a soggetti appartenenti a settori disciplinari diversi dal tuo (ma anche uguali al tuo).

Secondo l'amico (appunto), la traduzione corretta sarebbe un mai sentito "intervallo di fiducia". Io ho provato a cavarmela scherzandoci sopra (era il colpo d'avvertimento), e ricordando che "la fiducia si dà alle cose serie", e un segmento non è una caciotta.

Niente, ha insistito.

E allora selettore a raffica...

Dunque:

premesso che

pur rispettando la Magna Grecia e i suoi derivati (come del resto la Lapponia o la Casamance) non accetto lezioni di italiano da chiunque non sia nato all'interno del quadrilatero di coordinate 43.789594, 11.228359; 43.787239, 11.284664; 43.759224, 11.241202; 43.759286, 11.266007 (e mi son tenuto largo),

considerato che

il soggetto in questione proviene da un ambiente svantaggiato ed è finito in un ambiente svantaggiatissimo (vedi areale stepposo, non do le coordinate), il che costituisce attenuante specifica

viste le voci

"confidenza" del Dizionario Devoto-Oli e "confidenze" del Dizionario Sansoni, che si riportano in allegato al dispositivo della sentenza, questo organo monocratico

stabilisce quanto segue

clicca e ascolta bene.

"Intervallo di confidenza" è una traduzione perfettamente legittima di "confidence interval" (a meno che tu non voglia insegnare l'italiano a De Finetti, perché con me ti dice male), atteso che la prima traduzione di confidence nel senso di trust, reliance è appunto "confidenza" (e l'intervallo di confidenza a cosa serve, se non a valutare la reliability di una previsione, o, come nel post precedente, la sua totale infondatezza), e che il terzo significato di confidenza è appunto fiducia (che copre un campo semantico lievemente diverso).

Ora, vedi, io non vorrei dirtelo, ma mentre le anaconde e le malgame non esistono (esistono gli anaconda e gli amalgama, però: i primi non li ho mai incontrati, tu hai forse incontrato i secondi), mentre una decade non è un decennio (ma va?), mentre seminale in italiano è una cosa liquida, non una cosa avanzata (nel senso di pionieristica, perché in effetti anche cose seminali possono avanzare, anche se poi si seccano, come mi sto seccando io, ma in un modo diverso), d'altro canto "intervallo di confidenza" si può dire, è una traduzione assolutamente corretta.

Torno a ripeterlo, serenamente, laicamente: non è colpa mia se non siete nati all'interno delle quattro coordinate di cui sopra; non è colpa mia se avete passato la vita a leggere le traduzioni dei romanzi sbagliati. Fosse anche una colpa, io non vi giudicherei per questo. Chi sono io per giudicare? Sapete, nel Vecchio Testamento ci sono tante cose, e c'è anche una versione universalmente nota della morale della favola: il Salmo 129, che qui vi propongo in una delle sue versioni più convincenti: So du willst, Herr, Suende su rechnen... (e solo chi c'è stato dentro sa cos'è).

Però, per favore: abbiamo già avuto un vivaista commissario dell'ANVUR. Risparmiamoci il matematico Accademico della Crusca.

Bene.

Seguono gli allegati, e tranquillo: ti è andata bene.

Allegati

(ah, ovviamente il post vale per te, ma vale anche per l'altro. Lui sa chi è...)

(se non basta, ce n'è ancora...)

("qui è la mia volontà contro la vostra e voi avete già perso. Quando sembrerete degli economisti, comincerete a pensare da economisti". Basta avere gli strumenti didattici appropriati... Ah, naturalmente gli Stati Uniti non sono nazionalisti, Clint sta esagerando...)

I benefici di Renzi: il piciernile nel modello di a/simmetrie

Avendovi parlato dei costi di Monti, argomento che approfondiremo, vorrei per simmetria parlarvi dei vantaggi di Renzi. Vi ricorderete che all'annuncio dei famosi 80 euro in busta, la competente deputata del PD Pina Picierno ebbe a dire ex cathedra che i consumi sarebbero aumentati del 15% (ovviamente, sulla base di una stima dell'attendibile CENSIS, che i suoi conti li sa fare molto bene). Era ovviamente una scemenza plateale, rivelatrice di una ignoranza crassa dei più elementari fatti stilizzati macroeconomici. I consumi italiani, se pure in caduta libera, viaggiano sugli 800 miliardi di euro, il 15% di 800 miliardi è 0.15x800=120 miliardi, si stimava che la manovra avrebbe redistribuito alle famiglie circa 7 miliardi di euro (vedi oltre), quindi per l'onorevole Picierno 7 miliardi di spesa avrebbero generato 120 miliardi di Pil (perché i consumi, come sapete, sono una componente del Pil: Y = C + G + I + X - M), ovvero per l'onorevole Picierno il moltiplicatore dell'economia italiana è di 120/7=17.1.

Se pensate che Francesco Lippi mi ha amichevolmente "cazziato" perché in a/simmetrie il moltiplicatore va a 1.8 in recessione (cosa ampiamente ammessa dalla letteratura scientifica, peraltro), c'è da chiedersi cosa farebbe all'onorevole Picierno se la incontrasse.

Ma qui si entra nel campo dei sentimenti, e io preferisco restare in quello della scienza.

Il nostro liberista di riferimento creò per l'occasione l'espressione piciernile, una nuova unità di misura, specificamente ideata per misurare i grandi successi del governo Renzi. Inutile dire che siccome l'onorevole Picierno viene trovata avvenente da alcuni italiani medi (soprattutto di area renziana), il nostro liberista di riferimento venne travolto da una valanga di contumelie che in particolare gli rimproveravano un supposto "sessismo". In realtà né Puglisi né alcuno si era azzardato nemmeno a pensare che l'onorevole Picierno avesse detto una scemenza perché donna e/o perché bella. Ma d'altra parte il fatto che fosse donna non poteva costituire elemento ostativo all'evidenziare come quella detta fosse una plateale scemenza.

Sarebbe ben triste se il PD si servisse delle donne come certe organizzazioni criminali si servono dei bambini, mandati a compiere piccoli (ma fastidiosi) crimini perché virtualmente non incriminabili!

A suo tempo vennero fatte analisi serie ed approfondite. Ricordo appassionati scambi di tweet fra Nannicini e Manfredi su quale sarebbe stato il moltiplicatore di questi 80 euro. Tutta una serqua di interessanti disquisizioni su come la propensione al consumo vari fra le diverse categorie di percettori, su come ci sarebbe voluto un modello microeconomico, ecc. ecc. Il modello di a/simmetrie non c'era. Se ci fosse stato, in un decimo di secondo avrebbe potuto produrre, nella rozzezza (si fa per dire) del suo approccio macroeconomico, i risultati che vedete qua sotto.

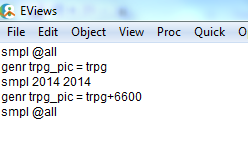

Per simulare il piciernile abbiamo incrementato di 6600 milioni (6,6 miliardi, l'importo della manovra nel 2014 secondo i tecnici del Senato) i trasferimenti alle famiglie (variabile TRPG del modello). Attraverso le equazioni [5.5], [5.8], e [5.10] (Appendice 4) questa variabile influisce direttamente sul reddito nominale delle famiglie. In linguaggio Eviews (se interessa) si tratta di scrivere queste poche righe:

Poi si fa un clic, e escono i risultati:

Secondo il modello, l'aumento in termini di reddito disponibile reale (cioè deflazionato per l'indice dei prezzi al consumo, cioè espresso in termini di effettivo potere di acquisto: è la variabile YDHR del modello) sarebbe stato lievemente inferiore (6,4 miliardi), per vari motivi, fra i quali il sia pur infinitesimo impatto della manovra sui prezzi. Ma qui siamo sui decimali. Comunque, il reddito disponibile sarebbe aumentato dello 0.71% in termini reali. L'aumento dei consumi in termini reali (CPV) sarebbe quindi stato dello 0.51% (abbastanza vicino al 15%, in effetti: basta scambiare le cifre e moltiplicare per 100). L'aumento del Pil (variabile GDPV) sarebbe stato quindi di 3207 milioni, cioè lo 0.24%. Le ultime tre righe riportano il tasso di crescita reale (cioè il % ch. a.r. = % change annual rate = variazione percentuale annua di GDPV): invece del -0.75% dello scenario di riferimento, avremmo avuto un -0.51%.

Questa valutazione macroeconomica ottenuta in quindici secondi coincide, se ci fate caso, con la più strutturata e competente valutazione fornita da Montella e Mostacci, che parlano di un aumento del Pil dello 0.32% senza considerare gli impatti collaterali, determinati in particolare dalle modalità prescelte per il finanziamento del bonus (che questa simulazione altresì non considera, mentre considera i feedback di tipo macroeconomico: ad esempio, l'aumento dei prezzi).

C'è poi da considerare una cosa, che magari sfugge. Il futuro, si sa, è incerto. Tutti questi ragionamenti non ne tengono conto, ma il modello sì, può farlo. Come? Ve lo spiego con calma un'altra volta: diciamo che il metodo si chiama "simulazione stocastica" e si basa sul simulare il modello tenendo conto del fatto che ogni equazione è soggetta a un errore statistico per i motivi che ho cercato di spiegarvi qui. In pratica, ogni equazione viene "shockata" aggiungendole un "disturbo" aleatorio estratto da una distribuzione gaussiana convenientemente scelta, che misura appunto l'incertezza (si può anche usare il bootstrap, per chi sa cos'è, così evitiamo: "Maestra? Perché non hai usato il bootstrap?", cui immediatamente segue la mia emotional response: "Sai cosa ti dice il bootstrap?").

Ora, il fatto è che quanto più precise sono le equazioni, cioè quanto meglio approssimano quello che è successo, tanto minore si suppone sia l'incertezza sul futuro. Il modello di a/simmetrie è singolarmente preciso. Lo scarto quadratico medio della simulazione stocastica del Pil è appena dell'1.5%. Vorrei vedere quelli della concorrenza. Il fatto è però che l'1.5% (cioè l'incertezza) è più dell'effetto atteso del piciernile (lo 0.24%), dal che consegue, in buona sostanza, che se costruiamo un intervallo di confidenza approssimato (cioè un intervallo all'interno del quale il Pil cadrebbe con probabilità 95%, costruito prendendo due s.q.m.), nonostante questo intervallo, nel caso del nostro modello, sia relativamente piccolo, l'impatto sul Pil prima e dopo il piciernile (impatto misurato dallo spostamento verso l'alto del quadratino blu) è largamente all'interno della banda di incertezza (misurata dalle sbarre rosse):

Questo significa che dal punto di vista statistico il piciernile è pari a zero, cioè, fuor di metafora, gli 80 euro di Renzi non hanno avuto un impatto percepibile ex post perché erano statisticamente non significativi ex ante.

Insomma, alla fine il risultato è stato zero, perché doveva essere zero, ed è per questo che le cose vanno come vanno.

Va da sé che questo risultato oggi, dopo che lo abbiamo constatato, non ci serve a molto. A me è servito per "validare" il modello. Secondo le nostre stime, dovremmo essere operativi a fine gennaio, cioè allo scadere del primo contratto di Christian, che stiamo cercando di rinnovare. Operativi significa che appena la Picierno parla, arriva il grafico (con tempi di reazione contenuti entro le 24 ore).

Una bella operazione di fact checking, non trovate?

Se pensate che Francesco Lippi mi ha amichevolmente "cazziato" perché in a/simmetrie il moltiplicatore va a 1.8 in recessione (cosa ampiamente ammessa dalla letteratura scientifica, peraltro), c'è da chiedersi cosa farebbe all'onorevole Picierno se la incontrasse.

Ma qui si entra nel campo dei sentimenti, e io preferisco restare in quello della scienza.

Il nostro liberista di riferimento creò per l'occasione l'espressione piciernile, una nuova unità di misura, specificamente ideata per misurare i grandi successi del governo Renzi. Inutile dire che siccome l'onorevole Picierno viene trovata avvenente da alcuni italiani medi (soprattutto di area renziana), il nostro liberista di riferimento venne travolto da una valanga di contumelie che in particolare gli rimproveravano un supposto "sessismo". In realtà né Puglisi né alcuno si era azzardato nemmeno a pensare che l'onorevole Picierno avesse detto una scemenza perché donna e/o perché bella. Ma d'altra parte il fatto che fosse donna non poteva costituire elemento ostativo all'evidenziare come quella detta fosse una plateale scemenza.

Sarebbe ben triste se il PD si servisse delle donne come certe organizzazioni criminali si servono dei bambini, mandati a compiere piccoli (ma fastidiosi) crimini perché virtualmente non incriminabili!

A suo tempo vennero fatte analisi serie ed approfondite. Ricordo appassionati scambi di tweet fra Nannicini e Manfredi su quale sarebbe stato il moltiplicatore di questi 80 euro. Tutta una serqua di interessanti disquisizioni su come la propensione al consumo vari fra le diverse categorie di percettori, su come ci sarebbe voluto un modello microeconomico, ecc. ecc. Il modello di a/simmetrie non c'era. Se ci fosse stato, in un decimo di secondo avrebbe potuto produrre, nella rozzezza (si fa per dire) del suo approccio macroeconomico, i risultati che vedete qua sotto.

Per simulare il piciernile abbiamo incrementato di 6600 milioni (6,6 miliardi, l'importo della manovra nel 2014 secondo i tecnici del Senato) i trasferimenti alle famiglie (variabile TRPG del modello). Attraverso le equazioni [5.5], [5.8], e [5.10] (Appendice 4) questa variabile influisce direttamente sul reddito nominale delle famiglie. In linguaggio Eviews (se interessa) si tratta di scrivere queste poche righe:

Poi si fa un clic, e escono i risultati:

Secondo il modello, l'aumento in termini di reddito disponibile reale (cioè deflazionato per l'indice dei prezzi al consumo, cioè espresso in termini di effettivo potere di acquisto: è la variabile YDHR del modello) sarebbe stato lievemente inferiore (6,4 miliardi), per vari motivi, fra i quali il sia pur infinitesimo impatto della manovra sui prezzi. Ma qui siamo sui decimali. Comunque, il reddito disponibile sarebbe aumentato dello 0.71% in termini reali. L'aumento dei consumi in termini reali (CPV) sarebbe quindi stato dello 0.51% (abbastanza vicino al 15%, in effetti: basta scambiare le cifre e moltiplicare per 100). L'aumento del Pil (variabile GDPV) sarebbe stato quindi di 3207 milioni, cioè lo 0.24%. Le ultime tre righe riportano il tasso di crescita reale (cioè il % ch. a.r. = % change annual rate = variazione percentuale annua di GDPV): invece del -0.75% dello scenario di riferimento, avremmo avuto un -0.51%.

Questa valutazione macroeconomica ottenuta in quindici secondi coincide, se ci fate caso, con la più strutturata e competente valutazione fornita da Montella e Mostacci, che parlano di un aumento del Pil dello 0.32% senza considerare gli impatti collaterali, determinati in particolare dalle modalità prescelte per il finanziamento del bonus (che questa simulazione altresì non considera, mentre considera i feedback di tipo macroeconomico: ad esempio, l'aumento dei prezzi).

C'è poi da considerare una cosa, che magari sfugge. Il futuro, si sa, è incerto. Tutti questi ragionamenti non ne tengono conto, ma il modello sì, può farlo. Come? Ve lo spiego con calma un'altra volta: diciamo che il metodo si chiama "simulazione stocastica" e si basa sul simulare il modello tenendo conto del fatto che ogni equazione è soggetta a un errore statistico per i motivi che ho cercato di spiegarvi qui. In pratica, ogni equazione viene "shockata" aggiungendole un "disturbo" aleatorio estratto da una distribuzione gaussiana convenientemente scelta, che misura appunto l'incertezza (si può anche usare il bootstrap, per chi sa cos'è, così evitiamo: "Maestra? Perché non hai usato il bootstrap?", cui immediatamente segue la mia emotional response: "Sai cosa ti dice il bootstrap?").

Ora, il fatto è che quanto più precise sono le equazioni, cioè quanto meglio approssimano quello che è successo, tanto minore si suppone sia l'incertezza sul futuro. Il modello di a/simmetrie è singolarmente preciso. Lo scarto quadratico medio della simulazione stocastica del Pil è appena dell'1.5%. Vorrei vedere quelli della concorrenza. Il fatto è però che l'1.5% (cioè l'incertezza) è più dell'effetto atteso del piciernile (lo 0.24%), dal che consegue, in buona sostanza, che se costruiamo un intervallo di confidenza approssimato (cioè un intervallo all'interno del quale il Pil cadrebbe con probabilità 95%, costruito prendendo due s.q.m.), nonostante questo intervallo, nel caso del nostro modello, sia relativamente piccolo, l'impatto sul Pil prima e dopo il piciernile (impatto misurato dallo spostamento verso l'alto del quadratino blu) è largamente all'interno della banda di incertezza (misurata dalle sbarre rosse):

Questo significa che dal punto di vista statistico il piciernile è pari a zero, cioè, fuor di metafora, gli 80 euro di Renzi non hanno avuto un impatto percepibile ex post perché erano statisticamente non significativi ex ante.

Insomma, alla fine il risultato è stato zero, perché doveva essere zero, ed è per questo che le cose vanno come vanno.

Va da sé che questo risultato oggi, dopo che lo abbiamo constatato, non ci serve a molto. A me è servito per "validare" il modello. Secondo le nostre stime, dovremmo essere operativi a fine gennaio, cioè allo scadere del primo contratto di Christian, che stiamo cercando di rinnovare. Operativi significa che appena la Picierno parla, arriva il grafico (con tempi di reazione contenuti entro le 24 ore).

Una bella operazione di fact checking, non trovate?

lunedì 29 dicembre 2014

Un esempio

Uga: "Perché lo fotografi? Fa ridere?"

Io: "Dipende. Che giorno è oggi?"

Uga: "Il 29, perché?"

Io: "Di agosto?"

Uga: "Ah, ho capito!"

Io: "Dipende. Che giorno è oggi?"

Uga: "Il 29, perché?"

Io: "Di agosto?"

Uga: "Ah, ho capito!"

domenica 28 dicembre 2014

Anche tu econometrico, prima lezione: le distribuzzioni

Ragazzi, io vi voglio bene, ed è anche Natale, ma vi devo dire una cosa: certe volte ho l'impressione di svuotare il mare col cucchiaio. Ho avuto un paio di domande in coda al post precedente che mi hanno gettato nella disperazione più cupa, ma... Sto appunto contando fino a un miliardo prima di rispondere. Comunque, visto che l'economia rinuncio a insegnarla, proviamo con qualcosa di più complicato. Magari riesce meglio. Potrebbe sembrare un paradosso, ma non lo è del tutto: l'ho imparato da Kees Boeke, che millanta anni fa, in una master class, a una pippa che aveva un problema ritmico in non so più quale cosa del Pastor Fido, disse: "Perché non fai i trilli?" Ora, visto che il problema era evidentemente il solfeggio, l'idea di insistere sugli abbellimenti poteva sembrare assolutamente bislacca. Eppure, il pisquano ricominciò coi trilli, e questa volta il pezzo quadrava. E la spiegazione di Boeke fu assolutamente esemplare: "Certe volte basta distrarre l'allievo per portarlo a fare la cosa giusta".

Ognuno di voi (maschietti) si è servito senza saperlo di questo saggio consiglio almeno una volta nella vita - tranne Simone Previti (tralascio ulteriori spiegazioni per evitare l'intervento del KPO).

Allora: visto che non riesco in nessun cazzo di modo a farvi capire una cosa assolutamente concreta (cioè che di norma è un media le persone preferiscono comprare lo stesso bene dove costa di meno), oggi ci dedichiamo a un passatempo astratto, che ci servirà però per focalizzare alcuni concetti dei quali avremo bisogno nella nostra futura comune carriera di previsori economici (avete un grande - e incerto - futuro) davanti.

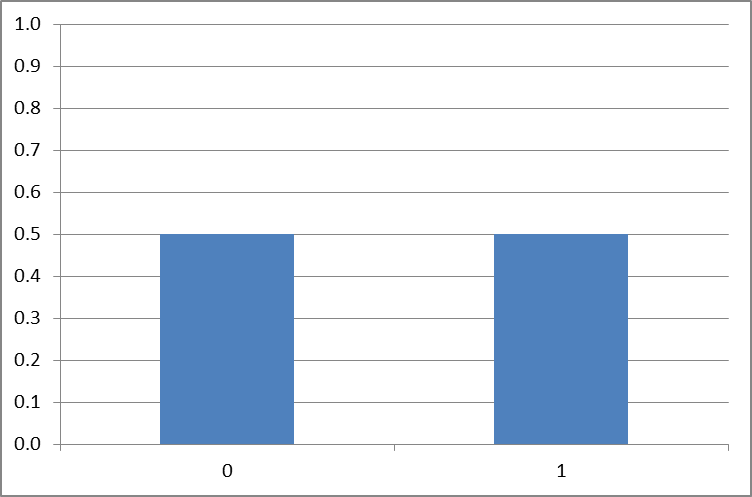

Supponiamo che non abbiate niente da fare e abbiate una moneta. La lanciate in aria e decidete che testa vale uno e croce vale zero. In linea teorica, potete aspettarvi che la probabilità di avere testa e quella di avere croce siano uguali. Ora, come saprete, le probabilità sono numeri compresi fra zero e uno. Quindi, se i due eventi che state considerando sono ugualmente probabili, entrambi avranno probabilità 0.5. Succede quindi una cosa di questo tipo (sempre parlando in astratto):

P(testa) + P(croce) = 0.5 + 0.5 = 1

Notate che un evento impossibile ha probabilità zero, per definizione. Far capire al piddino che il cambio flessibile non è immorale, per esempio, ha probabilità zero. L'evento certo, viceversa, ha probabilità uno. L'euro finirà con probabilità uno.

Allora, cosa significa, qua sopra, che la somma della probabilità di ottenere testa e di quella di ottenere croce è uno? Significa che se lanci la moneta, certamente otterrai o testa, o croce. Una delle due cose deve succedere per forza. Quindi 1 è la probabilità dell'evento: "o testa o croce". La somma delle probabilità indica la probabilità dell'evento che consiste nel verificarsi di almeno uno degli eventi le cui probabilità stai sommando (frase un po' complicata per un dopocena, ma se pensate all'esempio torna).

Fino a qui abbiamo parlato di quello che voi pensate sia probabile che accada: questa è la vostra percezione soggettiva della probabilità.Siamo quindi nel mondo della probabilità soggettiva.

Ma, tanto per dirne una, la moneta potrebbe essere sbilanciata. Magari da una parte è usurata, e quindi il suo baricentro la porta a cadere più spesso in un modo. Come si fa per verificarlo?

Ad esempio, un modo potrebbe essere lanciare la moneta in aria 100 volte, e poi dividere il numero delle teste ottenute per 100. Se la moneta è perfetta e avete fortuna, vi avvicinerete a 0.5.

Il numero che ottenete in questo modo è in effetti la frequenza relativa dell'evento testa: frequenza (cioè quando spesso capita) relativa (cioè riferita al numero totale di tentativi). Siamo nel mondo della probabilità frequentista.

Ora, qui si sono già aperti due mondi, quindi è meglio che li chiudiamo subito e facciamo un esempio. Siccome non ho niente da fare, ho lanciato cento volte una moneta in aria, e mi è successo questo:

Ops! Ho avuto 52 croci (che valgono zero) e quindi 48 teste (che valgono uno). La frequenza delle croci è stata 0.52, ed è in qualche modo una specie di "stima" della probabilità. Ora, direte voi, questo significa che la moneta è squilibrata? No, potrebbe anche significare che non ho provato abbastanza. D'altra parte, ripetendo l'esperimento, ho ottenuto:

...il 41% di croci: ma allora la moneta è squilibrata nell'altro modo? Bo'... Se ripeto l'esperimento:

...il 50% di croci e il 50% di teste... Le mie stime sono in effetti un po' ballerine: ripeto, forse 100 ripetizioni non sono abbastanza per ottenere una stima precisa della probabilità "vera", forse la probabilità "vera" nemmeno esiste, secondo von Mises dovreste ripetere l'esperimento infinite volte per avvicinarvici, ecc.

Notate come è fatta la distribuzione delle frequenze (probabilità?): è livellata, due valori uguali.

Oggi, però, non voglio parlarvi di questo. Diciamo che la frequenza relativa comunque una certa indicazione sulla probabilità di un evento (ripetibile) ce la dà, e vediamo cosa succede se consideriamo un evento di tipo diverso. Supponiamo che incontriate un vostro amico, e che decidiate di tirare in aria ognuno la sua moneta, sempre con la stessa regola: testa uno, croce zero, e di sommare i punteggi. Cosa può succedere? Se avete entrambi croce, la somma è zero. Se avete uno testa e l'altro croce, la somma è uno. Se avete entrambi testa, la somma è due.

Notate che i casi sono quattro:

tu croce, amico croce = 0

tu croce, amico testa = 1

tu testa, amico croce = 1

tu testa, amico testa = 2

Capite già che il "numero" che rischia di uscire più spesso, a questo giochetto è evidentemente l'uno, mentre lo zero e il due hanno probabilità più bassa. In effetti, prima ho incontrato un mio amico, ed è venuta fuori una cosa di questo tipo:

Ci sono uscite due teste 28 volte, due croci 24 volte, e una testa e una croce 48 volte. Vedete? In questo caso la distribuzione delle frequenze tende ad avere una forma a "tendina canadese": le frequenze (probabilità?) degli eventi estremi sono più passe, l'evento centrale (testa a uno e croce all'altro) è più frequente (probabile?). Notate che questo risultato si ottiene sommando due variabili "testa o croce" che invece hanno una distribuzione tendenzialmente livellata, piatta.

Poi, siccome ho tanti amici, passeggiando per il quartiere (perché non ho niente da fare, e del resto nemmeno loro, visto che sono statali improduttivi), ne ho presi una ventina, e gli ho chiesto: "Sentite, visto che non avete niente da fare, prendiamo ognuno una moneta, lanciamola in aria, poi sommiamo il numero delle teste: facciamolo cento volte, e vediamo che distribuzione di frequenze viene: se a tutti e venti esce croce, la somma sarà zero, se a tutti e venti esce testa, la somma sarà venti, in media dovrebbe venire un numero intorno a dieci". Lo abbiamo fatto, ed è venuto fuori questo:

Notate alcune cosette: le barre (frequenze) sono tutte più basse (relativamente piccole), e questo è ovvio: la probabilità totale è sempre uno, ma ora si distribuisce fra ventuno casi possibili, quindi a ogni caso tocca una probabilità più bassa. Notate anche che alcuni eventi non si sono mai verificati. Ad esempio, non è ma successo che tutti avessero croce (valore 0) o che tutti avessero testa (valore 20), ma nemmeno che 1 avesse testa e tutti gli altri croce (valore 1), o che uno solo avesse croce e tutti gli altri testa (valore 19). Viceversa, la cosa che è successa più spesso è che metà avessero testa, e metà croce: il valore 10 si è presentato nel 20% dei casi (frequenza relativa 0.2).

Notate anche che sommando venti variabili "testa o croce" dalla distribuzione piatta ("fifty fifty", 0.5-0.5, come nel terzo grafico sopra), abbiamo ottenuto una variabile dalla distribuzione lievemente "a campana", con un valore centrale più elevato, e valori lontani dalla media sempre meno probabili.

E ora, supponiamo di prendere tutti i piddini che ci circondano, ognuno con la sua monetina in mano, e di far loro lanciare la monetina in aria, per poi sommare i risultati, e calcolare la frequenza relativa. I piddini sono tanti: secondo la Bibbia, il loro numero è infinito. Cosa verrebbe fuori? Gli amici matematici lo sanno: una cosa molto simile a questa:

Si chiama curva gaussiana, o distribuzione normale di probabilità. Il teorema di De Moivre-Laplace ci dice appunto che se sommi un numero infinito di variabili casuali binomiali (sarebbero quelle somme delle quali vi ho parlato sopra), la distribuzione delle frequenze dei risultati seguirà una curva a campana di questo tipo. La dimostrazione, se interessa, è qui e a me la spiegò Gennaro Olivieri a Matematica finanziaria II. Da quel giorno capii che la matematica mi piaceva: veder emergere una distribuzione continua dalla somma di bernoulliane mi procurò una discreta (o continua) sindrome di Stendhal. In matematica, poi, sono beato come un economista. Ma forse ricorederte questa scena:

"Si intende di armi, mister Bond?" "No, mi intendo un po' di donne".

"Si intende di matematica, mister Bagnai?" "No, mi intendo un po' di bellezza".

E il teorema di de Moivre-Laplace è bello.

Ora voi direte: ma a noi che ce ne frega? E la risposta la so: niente. Però se vogliamo parlare di incertezza, se vogliamo veramente capire qualcosa di previsione, se vogliamo ragionare su quanto siano attendibili le previsioni del nostro modello (dove il "nostro" ovviamente si riferisce a chi ha pagato il biglietto, non ai pur graditi portoghesi), un po' di calcolo delle probabilità bisognerà pure che proviamo a impararlo.

Il risultato che vi ho fatto vedere è un caso particolare di un teorema di statistica noto come teorema limite centrale (ora arriva Basilisco, eccolo...), il cui senso è: se ripetiamo un certo evento per un numero sufficientemente elevato di volte, la distribuzione delle sue frequenze tenderà a una normale. In effetti, la normale si chiama così proprio perché è normale che eventi ripetuti obbediscano ad essa: l'evento più probabile, con la frequenza più alta, sarà quello che corrisponde al valore che ci aspettiamo in media, e a mano a mano che ci allontaniamo dalla media, la frequenza (probabilità) degli eventi sarà sempre più piccola, tendendo più o meno rapidamente a zero.

Ci serve?

Abbastanza sì.

Pensate ad esempio a quando abbiamo parlato della funzione del consumo. Abbiamo detto, con Keynes: "di norma e in media ogni individuo aumenta i propri consumi all'aumentare del reddito, ma non di tanto di quanto è aumentato il reddito".

Ad esempio, se un individuo consuma il 75% del reddito, mediamente succederà che C = 0.75 Y.

Ora, noi non osserviamo il consumo di "un individuo": potremmo anche farlo (se ci autorizza il magistrato), ma in macroeconomia, per fare prima, osserviamo i consumi di tutti gli individui. È possibile mai che tutti gli individui di un paese, posto anche che il loro desiderio sia di consumare esattamente e solo il 75% del proprio reddito, ci riescano sempre e comunque e in ogni anno?

La risposta, ovviamente, è no, per cui già possiamo immaginarci che anche a livello del singolo individuo il comportamento potrà essere meglio descritto da una cosa del tipo:

Ci = 0.75 Yi + ei

dove l'indice "i" indica l'individo e la lettera "e" indica l'errore, la distanza fra il valore teorico di quello che l'individuo avrebbe voluto consumare (o ci saremmo aspettati che consumasse), ovvero 0.75 Yi, e quello che effettivamente ha consumato, e noi vediamo nelle nostre statistiche, ovvero Ci. In altre parole, sarà:

ei = Ci - 0.75 Yi

(scarto fra valore misurato del consumo e valore teorico).

Ora, se non possiamo aspettarci che nessun individuo rispetti esattamente i propri piani di spesa, ovviamente nemmeno a livello aggregato questi saranno esattamente rispettati. In altre parole, anche la funzione aggregata del consumo avrà un qualche errore statistico, cioè sarà una cosa del tipo:

C = c Y + e

dove c è la propensione marginale al consumo, ed e è l'errore statistico della relazione aggregata.

Di questo errore noi non sappiamo nulla: se sapessimo qualcosa, ne terremmo conto nella nostra funzione, e magari la modificheremmo di conseguenza. Una cosa però la sappiamo: siccome l'errore e è la somma degli errori ei fatti da tanti individui i, per il teorema limite centrale la sua distribuzione di probabilità sarà normale.

Ovviamente

#CHEW

per ora, ma, come vedremo abbastanza rapidamente nei prossimi post, questa semplice informazione ci permette di effettuare previsioni che tengano conto in modo professionale dell'incertezza. Questo perché, in buona sostanza, sapere come è fatta la distribuzione di frequenza degli errori ci permette di calcolare quale è il margine di errore del nostro modello, con un grado di probabilità assegnato. Invece di dire: "il Pil crescerà dello 0.5%", potremo dire cosine un filo più sofisticate, del tipo: "il tasso di crescita del Pil cadrà, con una probabilità del 90%, in un intervallo fra -0.2% e 0.6%", tanto per dire.

Per ora vi do dei numeri a casaccio, ma poi, naturalmente, torniamo su tutto, comprese le domande che mi hanno dato la piacevole sensazione di star vuotando il mare col cucchiaio.

Pubblico senza rileggere perché ho il prof. Santarelli di sotto. Gli errori trovateli voi.

P.s.: ieri sera, sempre a proposito di bellezza, magnandome le cotolette d'abbacchio fritte co' li carciofi fritti in un ristorante goofyaccreditato (frequentato peraltro da economisti ortodossi del calibro di un... non ve lo dico!), dove ho incontrato l'amica Donna Olimpia (compagna di tante battaglie musicali), ho anche appreso (o saputo di apprendere) da Marco Basilisco che il teoremino di cui sopra ha a che fare col fatto che la normale è una distribuzione che massimizza l'entropia, e che Shannon aveva congetturato che il teorema limite centrale potesse in definitiva essere spiegato in questi termini, dal momento che ogni variabile aleatoria che aggiungi alla somma di fatto ne aumenta l'entropia. Avrò capito? Comunque anche i matematici non hanno capito subito, ci hanno messo un po' a dimostrare questa congettura, che se capisco bene generalizza il teorema limite centrale, o comunque ci arriva da un'altra strada. Dal che conseguono due corollari. Il primo è che l'attrazione di Basilisco per l'entropia motiva la sua attrazione per Rockapasso (soprannominata, appunto, "Entropia", dagli ingengngnieri che la frequentavano). La seconda, più superficiale, riguarda la natura della ricerca scientifica, che secondo Basilisco consiste nel trasformare una risposta in una domanda. Cioè: De Moivre a Laplace hanno risposto alla domanda "che succede alla distribuzione di una somma di binomiali?". E la risposta era: "È gaussiana". A questo punto l'econometrico ci lavora, e il ricercatore si chiede: "Ma perché è gaussiana?".

E poi si muore, soli, come si è soli quando si capisce.

Ognuno di voi (maschietti) si è servito senza saperlo di questo saggio consiglio almeno una volta nella vita - tranne Simone Previti (tralascio ulteriori spiegazioni per evitare l'intervento del KPO).

Allora: visto che non riesco in nessun cazzo di modo a farvi capire una cosa assolutamente concreta (cioè che di norma è un media le persone preferiscono comprare lo stesso bene dove costa di meno), oggi ci dedichiamo a un passatempo astratto, che ci servirà però per focalizzare alcuni concetti dei quali avremo bisogno nella nostra futura comune carriera di previsori economici (avete un grande - e incerto - futuro) davanti.

Supponiamo che non abbiate niente da fare e abbiate una moneta. La lanciate in aria e decidete che testa vale uno e croce vale zero. In linea teorica, potete aspettarvi che la probabilità di avere testa e quella di avere croce siano uguali. Ora, come saprete, le probabilità sono numeri compresi fra zero e uno. Quindi, se i due eventi che state considerando sono ugualmente probabili, entrambi avranno probabilità 0.5. Succede quindi una cosa di questo tipo (sempre parlando in astratto):

P(testa) + P(croce) = 0.5 + 0.5 = 1

Notate che un evento impossibile ha probabilità zero, per definizione. Far capire al piddino che il cambio flessibile non è immorale, per esempio, ha probabilità zero. L'evento certo, viceversa, ha probabilità uno. L'euro finirà con probabilità uno.

Allora, cosa significa, qua sopra, che la somma della probabilità di ottenere testa e di quella di ottenere croce è uno? Significa che se lanci la moneta, certamente otterrai o testa, o croce. Una delle due cose deve succedere per forza. Quindi 1 è la probabilità dell'evento: "o testa o croce". La somma delle probabilità indica la probabilità dell'evento che consiste nel verificarsi di almeno uno degli eventi le cui probabilità stai sommando (frase un po' complicata per un dopocena, ma se pensate all'esempio torna).

Fino a qui abbiamo parlato di quello che voi pensate sia probabile che accada: questa è la vostra percezione soggettiva della probabilità.Siamo quindi nel mondo della probabilità soggettiva.

Ma, tanto per dirne una, la moneta potrebbe essere sbilanciata. Magari da una parte è usurata, e quindi il suo baricentro la porta a cadere più spesso in un modo. Come si fa per verificarlo?

Ad esempio, un modo potrebbe essere lanciare la moneta in aria 100 volte, e poi dividere il numero delle teste ottenute per 100. Se la moneta è perfetta e avete fortuna, vi avvicinerete a 0.5.

Il numero che ottenete in questo modo è in effetti la frequenza relativa dell'evento testa: frequenza (cioè quando spesso capita) relativa (cioè riferita al numero totale di tentativi). Siamo nel mondo della probabilità frequentista.

Ora, qui si sono già aperti due mondi, quindi è meglio che li chiudiamo subito e facciamo un esempio. Siccome non ho niente da fare, ho lanciato cento volte una moneta in aria, e mi è successo questo:

Ops! Ho avuto 52 croci (che valgono zero) e quindi 48 teste (che valgono uno). La frequenza delle croci è stata 0.52, ed è in qualche modo una specie di "stima" della probabilità. Ora, direte voi, questo significa che la moneta è squilibrata? No, potrebbe anche significare che non ho provato abbastanza. D'altra parte, ripetendo l'esperimento, ho ottenuto:

...il 41% di croci: ma allora la moneta è squilibrata nell'altro modo? Bo'... Se ripeto l'esperimento:

...il 50% di croci e il 50% di teste... Le mie stime sono in effetti un po' ballerine: ripeto, forse 100 ripetizioni non sono abbastanza per ottenere una stima precisa della probabilità "vera", forse la probabilità "vera" nemmeno esiste, secondo von Mises dovreste ripetere l'esperimento infinite volte per avvicinarvici, ecc.

Notate come è fatta la distribuzione delle frequenze (probabilità?): è livellata, due valori uguali.

Oggi, però, non voglio parlarvi di questo. Diciamo che la frequenza relativa comunque una certa indicazione sulla probabilità di un evento (ripetibile) ce la dà, e vediamo cosa succede se consideriamo un evento di tipo diverso. Supponiamo che incontriate un vostro amico, e che decidiate di tirare in aria ognuno la sua moneta, sempre con la stessa regola: testa uno, croce zero, e di sommare i punteggi. Cosa può succedere? Se avete entrambi croce, la somma è zero. Se avete uno testa e l'altro croce, la somma è uno. Se avete entrambi testa, la somma è due.

Notate che i casi sono quattro:

tu croce, amico croce = 0

tu croce, amico testa = 1

tu testa, amico croce = 1

tu testa, amico testa = 2

Capite già che il "numero" che rischia di uscire più spesso, a questo giochetto è evidentemente l'uno, mentre lo zero e il due hanno probabilità più bassa. In effetti, prima ho incontrato un mio amico, ed è venuta fuori una cosa di questo tipo:

Ci sono uscite due teste 28 volte, due croci 24 volte, e una testa e una croce 48 volte. Vedete? In questo caso la distribuzione delle frequenze tende ad avere una forma a "tendina canadese": le frequenze (probabilità?) degli eventi estremi sono più passe, l'evento centrale (testa a uno e croce all'altro) è più frequente (probabile?). Notate che questo risultato si ottiene sommando due variabili "testa o croce" che invece hanno una distribuzione tendenzialmente livellata, piatta.

Poi, siccome ho tanti amici, passeggiando per il quartiere (perché non ho niente da fare, e del resto nemmeno loro, visto che sono statali improduttivi), ne ho presi una ventina, e gli ho chiesto: "Sentite, visto che non avete niente da fare, prendiamo ognuno una moneta, lanciamola in aria, poi sommiamo il numero delle teste: facciamolo cento volte, e vediamo che distribuzione di frequenze viene: se a tutti e venti esce croce, la somma sarà zero, se a tutti e venti esce testa, la somma sarà venti, in media dovrebbe venire un numero intorno a dieci". Lo abbiamo fatto, ed è venuto fuori questo:

Notate alcune cosette: le barre (frequenze) sono tutte più basse (relativamente piccole), e questo è ovvio: la probabilità totale è sempre uno, ma ora si distribuisce fra ventuno casi possibili, quindi a ogni caso tocca una probabilità più bassa. Notate anche che alcuni eventi non si sono mai verificati. Ad esempio, non è ma successo che tutti avessero croce (valore 0) o che tutti avessero testa (valore 20), ma nemmeno che 1 avesse testa e tutti gli altri croce (valore 1), o che uno solo avesse croce e tutti gli altri testa (valore 19). Viceversa, la cosa che è successa più spesso è che metà avessero testa, e metà croce: il valore 10 si è presentato nel 20% dei casi (frequenza relativa 0.2).

Notate anche che sommando venti variabili "testa o croce" dalla distribuzione piatta ("fifty fifty", 0.5-0.5, come nel terzo grafico sopra), abbiamo ottenuto una variabile dalla distribuzione lievemente "a campana", con un valore centrale più elevato, e valori lontani dalla media sempre meno probabili.

E ora, supponiamo di prendere tutti i piddini che ci circondano, ognuno con la sua monetina in mano, e di far loro lanciare la monetina in aria, per poi sommare i risultati, e calcolare la frequenza relativa. I piddini sono tanti: secondo la Bibbia, il loro numero è infinito. Cosa verrebbe fuori? Gli amici matematici lo sanno: una cosa molto simile a questa:

Si chiama curva gaussiana, o distribuzione normale di probabilità. Il teorema di De Moivre-Laplace ci dice appunto che se sommi un numero infinito di variabili casuali binomiali (sarebbero quelle somme delle quali vi ho parlato sopra), la distribuzione delle frequenze dei risultati seguirà una curva a campana di questo tipo. La dimostrazione, se interessa, è qui e a me la spiegò Gennaro Olivieri a Matematica finanziaria II. Da quel giorno capii che la matematica mi piaceva: veder emergere una distribuzione continua dalla somma di bernoulliane mi procurò una discreta (o continua) sindrome di Stendhal. In matematica, poi, sono beato come un economista. Ma forse ricorederte questa scena:

"Si intende di armi, mister Bond?" "No, mi intendo un po' di donne".

"Si intende di matematica, mister Bagnai?" "No, mi intendo un po' di bellezza".

E il teorema di de Moivre-Laplace è bello.

Ora voi direte: ma a noi che ce ne frega? E la risposta la so: niente. Però se vogliamo parlare di incertezza, se vogliamo veramente capire qualcosa di previsione, se vogliamo ragionare su quanto siano attendibili le previsioni del nostro modello (dove il "nostro" ovviamente si riferisce a chi ha pagato il biglietto, non ai pur graditi portoghesi), un po' di calcolo delle probabilità bisognerà pure che proviamo a impararlo.

Il risultato che vi ho fatto vedere è un caso particolare di un teorema di statistica noto come teorema limite centrale (ora arriva Basilisco, eccolo...), il cui senso è: se ripetiamo un certo evento per un numero sufficientemente elevato di volte, la distribuzione delle sue frequenze tenderà a una normale. In effetti, la normale si chiama così proprio perché è normale che eventi ripetuti obbediscano ad essa: l'evento più probabile, con la frequenza più alta, sarà quello che corrisponde al valore che ci aspettiamo in media, e a mano a mano che ci allontaniamo dalla media, la frequenza (probabilità) degli eventi sarà sempre più piccola, tendendo più o meno rapidamente a zero.

Ci serve?

Abbastanza sì.

Pensate ad esempio a quando abbiamo parlato della funzione del consumo. Abbiamo detto, con Keynes: "di norma e in media ogni individuo aumenta i propri consumi all'aumentare del reddito, ma non di tanto di quanto è aumentato il reddito".

Ad esempio, se un individuo consuma il 75% del reddito, mediamente succederà che C = 0.75 Y.

Ora, noi non osserviamo il consumo di "un individuo": potremmo anche farlo (se ci autorizza il magistrato), ma in macroeconomia, per fare prima, osserviamo i consumi di tutti gli individui. È possibile mai che tutti gli individui di un paese, posto anche che il loro desiderio sia di consumare esattamente e solo il 75% del proprio reddito, ci riescano sempre e comunque e in ogni anno?

La risposta, ovviamente, è no, per cui già possiamo immaginarci che anche a livello del singolo individuo il comportamento potrà essere meglio descritto da una cosa del tipo:

Ci = 0.75 Yi + ei

dove l'indice "i" indica l'individo e la lettera "e" indica l'errore, la distanza fra il valore teorico di quello che l'individuo avrebbe voluto consumare (o ci saremmo aspettati che consumasse), ovvero 0.75 Yi, e quello che effettivamente ha consumato, e noi vediamo nelle nostre statistiche, ovvero Ci. In altre parole, sarà:

ei = Ci - 0.75 Yi

(scarto fra valore misurato del consumo e valore teorico).

Ora, se non possiamo aspettarci che nessun individuo rispetti esattamente i propri piani di spesa, ovviamente nemmeno a livello aggregato questi saranno esattamente rispettati. In altre parole, anche la funzione aggregata del consumo avrà un qualche errore statistico, cioè sarà una cosa del tipo:

C = c Y + e

dove c è la propensione marginale al consumo, ed e è l'errore statistico della relazione aggregata.

Di questo errore noi non sappiamo nulla: se sapessimo qualcosa, ne terremmo conto nella nostra funzione, e magari la modificheremmo di conseguenza. Una cosa però la sappiamo: siccome l'errore e è la somma degli errori ei fatti da tanti individui i, per il teorema limite centrale la sua distribuzione di probabilità sarà normale.

Ovviamente

#CHEW

per ora, ma, come vedremo abbastanza rapidamente nei prossimi post, questa semplice informazione ci permette di effettuare previsioni che tengano conto in modo professionale dell'incertezza. Questo perché, in buona sostanza, sapere come è fatta la distribuzione di frequenza degli errori ci permette di calcolare quale è il margine di errore del nostro modello, con un grado di probabilità assegnato. Invece di dire: "il Pil crescerà dello 0.5%", potremo dire cosine un filo più sofisticate, del tipo: "il tasso di crescita del Pil cadrà, con una probabilità del 90%, in un intervallo fra -0.2% e 0.6%", tanto per dire.

Per ora vi do dei numeri a casaccio, ma poi, naturalmente, torniamo su tutto, comprese le domande che mi hanno dato la piacevole sensazione di star vuotando il mare col cucchiaio.

Pubblico senza rileggere perché ho il prof. Santarelli di sotto. Gli errori trovateli voi.

P.s.: ieri sera, sempre a proposito di bellezza, magnandome le cotolette d'abbacchio fritte co' li carciofi fritti in un ristorante goofyaccreditato (frequentato peraltro da economisti ortodossi del calibro di un... non ve lo dico!), dove ho incontrato l'amica Donna Olimpia (compagna di tante battaglie musicali), ho anche appreso (o saputo di apprendere) da Marco Basilisco che il teoremino di cui sopra ha a che fare col fatto che la normale è una distribuzione che massimizza l'entropia, e che Shannon aveva congetturato che il teorema limite centrale potesse in definitiva essere spiegato in questi termini, dal momento che ogni variabile aleatoria che aggiungi alla somma di fatto ne aumenta l'entropia. Avrò capito? Comunque anche i matematici non hanno capito subito, ci hanno messo un po' a dimostrare questa congettura, che se capisco bene generalizza il teorema limite centrale, o comunque ci arriva da un'altra strada. Dal che conseguono due corollari. Il primo è che l'attrazione di Basilisco per l'entropia motiva la sua attrazione per Rockapasso (soprannominata, appunto, "Entropia", dagli ingengngnieri che la frequentavano). La seconda, più superficiale, riguarda la natura della ricerca scientifica, che secondo Basilisco consiste nel trasformare una risposta in una domanda. Cioè: De Moivre a Laplace hanno risposto alla domanda "che succede alla distribuzione di una somma di binomiali?". E la risposta era: "È gaussiana". A questo punto l'econometrico ci lavora, e il ricercatore si chiede: "Ma perché è gaussiana?".

E poi si muore, soli, come si è soli quando si capisce.

sabato 27 dicembre 2014

Quick post su keynesiani, competitività e lungo periodo (KPD7)

So che non ve ne eravate accorti, ma devo confidarvi un mio piccolo segreto: sono molto tignoso e competitivo. Quando mi sfidano o mi provocano non riesco a tirarmi indietro. Cerco di nasconderlo, e so di riuscirci molto bene (vero?), ma purtroppo rimango spesso vittima di questo mio lieve difetto.

Ora, dopo che una interminata schiera di cialtroni mi ha attaccato con argomenti ad hominem del tipo: "quello non vale niente perché insegna in un'università di provincia", ho deciso di dedicare più tempo a quel simpatico (ma relativamente sterile) gioco intellettuale che si chiama "ricerca scientifica", e come vi ho fatto vedere già in un annetto son salito su per i ranking internazionali. Ora sono al 9% (quindi ho già sorpassato molti dei sullodati cialtroni), posso smettere quando voglio, ma ovviamente non prima di essere nel world top 5%. Mica per niente, eh! Lo faccio perché voi possiate essere fieri di me, s'intende...

Detto questo, la vita è un un inferno già al 9%. È un continuo di richieste di "referare" papers, e naturalmente di richieste di rispondere ai "referaggi" dei miei, di papers. Oggi mi sto dedicando a questa simpatica attività, e sono incappato nel solito keynesiano, quello che: "i neoclassici credono che l'aggiustamento avvenga tramite prezzi relativi, io non sono neoclassico, i prezzi relativi non contano" (come abbiamo visto in KPD2). Per i keynesiani per caso, in particolare, i prezzi relativi (cioè il rapporto fra i prezzi di due beni, insomma, quello che i comuni mortali chiamerebbero: "la convenienza") non hanno importanza nel lungo periodo, perché in media saranno sicuramente costanti.

Non so se sia un sillogismo (ai bei tempi avevamo con noi un filosofo), ma certamente è una lieve imprecisione, insomma: una sesquipedale cazzata. Qui c'è un problema di fondo, che è quello di capire cosa sia il lungo periodo. Una questione epistemologicamente complessa che non possiamo affrontare qui, dato che il post è rapido (cioè di breve periodo). Comunque, more on this later. Rimane il fatto che questo discorsetto in pratica non si applica ad almeno due categorie di paesi sottosviluppati: quelli esportatori di materie prime, vittime della secolare tendenza negativa delle ragioni di scambio dei loro prodotti, documentata da esempio qui, e quelli della periferia dell'Eurozona, vittime dell'ordoliberismo tedesco, illustrato da Cesaratto qui.

In sintesi, la pluridecennale tendenza tedesca alla deflazione, evocata da Meade nel suo articolo del 1957, e realizzata comprimendo la crescita salariale al di sotto di quella della produttività, ha una ovvia e spiacevole conseguenza: la Germania pratica una svalutazione reale competitiva di lungo periodo contro i suoi partner europei.

Lo dicono i dati, non lo dico io. Vi fornisco tre misure di questa mia asserzione, due ricavate (imperfettamente) dalle statistiche del Fmi, e una dal database del modello (per la sua costruzione potete leggervi la pagina 10 dell'articolo).

Prima però vi ricordo brevemente cosa è il tasso di cambio reale: è il rapporto fra il livello dei prezzi di due paesi, espressi in una comune valuta. Certo che non mi serve a nulla sapere che un cacciavite costa 29590 won coreani se non so quanto vale un won! (Eh, il wonnetto! Avercelo!...) Lo stesso valeva per i prezzi tedeschi: per esprimerli in una valuta comune fino al 1999 era necessario usare il cambio lira/marco. Dal 1999 questo cambio non c'è più (abbiamo visto com'è successo), ma questo ovviamente non altera la logica del ragionamento: semplicemente, facilita il confronto fra i nostri prezzi e i loro.

Un paio di formulette per capirsi. I tassi di cambio effettivi reali di Italia e Germania (dove "effettivi" significa: considerando come partner il resto del mondo) possono essere espressi in questo modo:

Al numeratore abbiamo i prezzi del paese in valuta nazionale, convertiti in valuta "mondiali" (es.: dollari) con un tasso valuta nazionale/dollaro; al numeratore abbiamo i prezzi medi "mondiali". La struttura è la stessa. Se vogliamo passare da un cambio effettivo a un cambio "bilaterale" (cioè: non Germania contro mondo, ma Germania contro Italia), una misura approssimata ce la dà il rapporto fra i rispettivi cambi effettivi, perché:

ovvero, il rapporto fra i rispettivi cambi effettivi è pari al rapporto fra i prezzi nazionali (nell'esempio, quelli di Germania e Italia) espressi in una comune valuta "mondiale". Se questo rapporto scende, la Germania sta svalutando.

Per il keynesiano doc questo rapporto deve essere fisso a uno, perché siccome i neoclassici neolibberisti neobbrutti e neocattivi neocredono che i prezzi contino, allora i prezzi non devono contare, e quindi (?) devono essere fissi. Ribadisco che in questo modo i "keynesiani per caso" si intrappolano da soli nella visione caricaturale che del keynesismo hanno confezionato i neoclassici: quella di un caso particolare del modello "vero" (che per i neoclassici è ovviamente il loro: ogni scarrafone è bello a mamma sua), dove però i prezzi sono fissi.

Non so perché i keynesiani siano così smaniosi di spiaggiarsi: come spiego in L'Italia può farcela, lo spiaggiamento è una prassi comune presso i mammiferi che hanno o credono di avere un cervello più pesante di quello altrui.

Dedicato quindi ai keynesiani per caso, oltre che al babbo di Luciano, il post precedente, procedo a mostrarvi i dati:

Le misure che vi mostro sono tre: CPI è il rapporto fra gli indici di tasso di cambio reale Fmi basati sugli indici dei prezzi al consumo, ULC è il rapporto fra gli indici di tasso di cambio reale Fmi basati sul costo del lavoro per unità di prodotto, e model è la misura del cambio bilaterale fra Italia e "core Eurozone" utilizzata nel modello. Notate che le prime due sono specificamente riferite al rapporto Germania/Italia. La nostra (model) è riferita al rapporto Italia/nucleo dell'Eurozona. Credo sia per questo che negli anni '80 mostra una minore tendenza alla svalutazione (discesa) di quella basata sul CPI: quest'ultima è riferita alla sola Germania, mentre la nostra considera anche paesi come la Francia, con inflazione relativamente più elevata. Si vede molto bene come prima dell'episodio del 1992-1993 vi fosse una tendenza alla svalutazione della Germania (o del nucleo dell'Eurozona) rispetto all'Italia, interrotta dalla crisi del 1992 che ripristinò la convenienza delle merci italiane rendendo meno cara la valuta italiana (nel grafico vedete la nostra svalutazione come una rivalutazione tedesca, ovviamente), e poi ripresa dal 1995. Il senso quindi è che tutte le misure concordano su un punto: dal 1995 la Germania sta svalutando competitivamente rispetto a noi (e sono ormai vent'anni), e prima del 1992 i dati mostrano sostanzialmente una tendenza analoga (va in controtendenza l'indicatore basato sul costo del lavoro). Sarebbe interessante andare più indietro: ora non ho tempo di farlo, ma se Meade non era un fesso immagino cosa troveremmo...

Naturalmente, va da sé, venti anni non sono il lungo periodo, per un keynesiano doc e per lui. Tuttavia, se il tuo campione di dati è di vent'anni e te ttu poni pari a zero per tigna ideologica il tasso di variazione del tasso di cambio reale (che invece nel caso della relazione Germania/Italia è evidentemente negativo, visto che questa variabile diminuisce regolarmente dal 1995), la tua equazione soffrirà di omitted variable bias, cioè, in parole povere, sarà pronta per la stampante della Merkel.

Mi avete capito?

E ora speriamo che mi capisca il referee...

Ora, dopo che una interminata schiera di cialtroni mi ha attaccato con argomenti ad hominem del tipo: "quello non vale niente perché insegna in un'università di provincia", ho deciso di dedicare più tempo a quel simpatico (ma relativamente sterile) gioco intellettuale che si chiama "ricerca scientifica", e come vi ho fatto vedere già in un annetto son salito su per i ranking internazionali. Ora sono al 9% (quindi ho già sorpassato molti dei sullodati cialtroni), posso smettere quando voglio, ma ovviamente non prima di essere nel world top 5%. Mica per niente, eh! Lo faccio perché voi possiate essere fieri di me, s'intende...

Detto questo, la vita è un un inferno già al 9%. È un continuo di richieste di "referare" papers, e naturalmente di richieste di rispondere ai "referaggi" dei miei, di papers. Oggi mi sto dedicando a questa simpatica attività, e sono incappato nel solito keynesiano, quello che: "i neoclassici credono che l'aggiustamento avvenga tramite prezzi relativi, io non sono neoclassico, i prezzi relativi non contano" (come abbiamo visto in KPD2). Per i keynesiani per caso, in particolare, i prezzi relativi (cioè il rapporto fra i prezzi di due beni, insomma, quello che i comuni mortali chiamerebbero: "la convenienza") non hanno importanza nel lungo periodo, perché in media saranno sicuramente costanti.

Non so se sia un sillogismo (ai bei tempi avevamo con noi un filosofo), ma certamente è una lieve imprecisione, insomma: una sesquipedale cazzata. Qui c'è un problema di fondo, che è quello di capire cosa sia il lungo periodo. Una questione epistemologicamente complessa che non possiamo affrontare qui, dato che il post è rapido (cioè di breve periodo). Comunque, more on this later. Rimane il fatto che questo discorsetto in pratica non si applica ad almeno due categorie di paesi sottosviluppati: quelli esportatori di materie prime, vittime della secolare tendenza negativa delle ragioni di scambio dei loro prodotti, documentata da esempio qui, e quelli della periferia dell'Eurozona, vittime dell'ordoliberismo tedesco, illustrato da Cesaratto qui.

In sintesi, la pluridecennale tendenza tedesca alla deflazione, evocata da Meade nel suo articolo del 1957, e realizzata comprimendo la crescita salariale al di sotto di quella della produttività, ha una ovvia e spiacevole conseguenza: la Germania pratica una svalutazione reale competitiva di lungo periodo contro i suoi partner europei.

Lo dicono i dati, non lo dico io. Vi fornisco tre misure di questa mia asserzione, due ricavate (imperfettamente) dalle statistiche del Fmi, e una dal database del modello (per la sua costruzione potete leggervi la pagina 10 dell'articolo).

Prima però vi ricordo brevemente cosa è il tasso di cambio reale: è il rapporto fra il livello dei prezzi di due paesi, espressi in una comune valuta. Certo che non mi serve a nulla sapere che un cacciavite costa 29590 won coreani se non so quanto vale un won! (Eh, il wonnetto! Avercelo!...) Lo stesso valeva per i prezzi tedeschi: per esprimerli in una valuta comune fino al 1999 era necessario usare il cambio lira/marco. Dal 1999 questo cambio non c'è più (abbiamo visto com'è successo), ma questo ovviamente non altera la logica del ragionamento: semplicemente, facilita il confronto fra i nostri prezzi e i loro.

Un paio di formulette per capirsi. I tassi di cambio effettivi reali di Italia e Germania (dove "effettivi" significa: considerando come partner il resto del mondo) possono essere espressi in questo modo:

Al numeratore abbiamo i prezzi del paese in valuta nazionale, convertiti in valuta "mondiali" (es.: dollari) con un tasso valuta nazionale/dollaro; al numeratore abbiamo i prezzi medi "mondiali". La struttura è la stessa. Se vogliamo passare da un cambio effettivo a un cambio "bilaterale" (cioè: non Germania contro mondo, ma Germania contro Italia), una misura approssimata ce la dà il rapporto fra i rispettivi cambi effettivi, perché:

ovvero, il rapporto fra i rispettivi cambi effettivi è pari al rapporto fra i prezzi nazionali (nell'esempio, quelli di Germania e Italia) espressi in una comune valuta "mondiale". Se questo rapporto scende, la Germania sta svalutando.

Per il keynesiano doc questo rapporto deve essere fisso a uno, perché siccome i neoclassici neolibberisti neobbrutti e neocattivi neocredono che i prezzi contino, allora i prezzi non devono contare, e quindi (?) devono essere fissi. Ribadisco che in questo modo i "keynesiani per caso" si intrappolano da soli nella visione caricaturale che del keynesismo hanno confezionato i neoclassici: quella di un caso particolare del modello "vero" (che per i neoclassici è ovviamente il loro: ogni scarrafone è bello a mamma sua), dove però i prezzi sono fissi.

Non so perché i keynesiani siano così smaniosi di spiaggiarsi: come spiego in L'Italia può farcela, lo spiaggiamento è una prassi comune presso i mammiferi che hanno o credono di avere un cervello più pesante di quello altrui.

Dedicato quindi ai keynesiani per caso, oltre che al babbo di Luciano, il post precedente, procedo a mostrarvi i dati:

Le misure che vi mostro sono tre: CPI è il rapporto fra gli indici di tasso di cambio reale Fmi basati sugli indici dei prezzi al consumo, ULC è il rapporto fra gli indici di tasso di cambio reale Fmi basati sul costo del lavoro per unità di prodotto, e model è la misura del cambio bilaterale fra Italia e "core Eurozone" utilizzata nel modello. Notate che le prime due sono specificamente riferite al rapporto Germania/Italia. La nostra (model) è riferita al rapporto Italia/nucleo dell'Eurozona. Credo sia per questo che negli anni '80 mostra una minore tendenza alla svalutazione (discesa) di quella basata sul CPI: quest'ultima è riferita alla sola Germania, mentre la nostra considera anche paesi come la Francia, con inflazione relativamente più elevata. Si vede molto bene come prima dell'episodio del 1992-1993 vi fosse una tendenza alla svalutazione della Germania (o del nucleo dell'Eurozona) rispetto all'Italia, interrotta dalla crisi del 1992 che ripristinò la convenienza delle merci italiane rendendo meno cara la valuta italiana (nel grafico vedete la nostra svalutazione come una rivalutazione tedesca, ovviamente), e poi ripresa dal 1995. Il senso quindi è che tutte le misure concordano su un punto: dal 1995 la Germania sta svalutando competitivamente rispetto a noi (e sono ormai vent'anni), e prima del 1992 i dati mostrano sostanzialmente una tendenza analoga (va in controtendenza l'indicatore basato sul costo del lavoro). Sarebbe interessante andare più indietro: ora non ho tempo di farlo, ma se Meade non era un fesso immagino cosa troveremmo...

Naturalmente, va da sé, venti anni non sono il lungo periodo, per un keynesiano doc e per lui. Tuttavia, se il tuo campione di dati è di vent'anni e te ttu poni pari a zero per tigna ideologica il tasso di variazione del tasso di cambio reale (che invece nel caso della relazione Germania/Italia è evidentemente negativo, visto che questa variabile diminuisce regolarmente dal 1995), la tua equazione soffrirà di omitted variable bias, cioè, in parole povere, sarà pronta per la stampante della Merkel.

Mi avete capito?

E ora speriamo che mi capisca il referee...

venerdì 26 dicembre 2014

Trauermusik (a Luciano)

...heute wirst du mit mir im Paradies sein.

(...e pensa che quello non era lì per caso: era stato un ladrone, come Monti, tanto per restare in argomento...)

Il costo di Monti (KPD6)

(...sesto capitolo del Keynesianesimo per le dame...)

(...il 2015 sarà un anno lunghissimo. Da più parti, tutte qualificatissime,

sento portare avanti un’interpretazione che mi sembra plausibile, che in parte

altera il quadro del Tramonto dell’euro, ma che si integra molto bene con le

consapevolezze faticosamente raggiunte in questi anni di studio comune. L’euro

è un progetto di annessione monetaria, ma non da parte della Germania, che,

come al solito nella SStoria, conta meno di quanto creda: da parte degli Stati

Uniti. Anche qui, per favore, astenersi complottisti. L’ho sentito io, con le

mie orecchie, Mundell raccontarci, a Dublino nel 2007,

che un pezzo del processo da lui auspicato verso la moneta

unica mondiale avrebbe dovuto essere la fusione di dollaro e euro. Dopo il

Risorgimento e l’Unione Europea sappiamo bene quale sia il risultato della “fusione”

fra un vaso di ferro e un vaso di coccio: chi ancora non lo sa si legga Anschluss

in ginocchio sui ceci. Fra Stati Uniti e “Europa” non devo certo spiegarvi

quale sia il vaso di coccio. D’altra parte, questo quadra perfettamente con una

cosa che abbiamo mille e una volta affermato (l’ultima

volta qui): quello che a economisti del

calibro di un Fazi e di un Pittella appare come un momento alto di

elaborazione politica europea, in realtà è il momento più basso di

sottomissione culturale a paradigmi statunitensi vetusti e fallimentari, alla

paccottiglia della scuola di Chicago (con la quale del resto Mundell è

consustanziale). Basterebbe l’idolatria per le regole fisse a dimostrarlo. È

roba europea? Come

no!? Chiaro, vero? Ma non possiamo chiedere di capirlo a un uomo che pure,

dovendo il proprio successo all’aver pubblicato una

storia di rapporti anali, parte in qualche modo avvantaggiato! D’altra

parte, l’annessione ha una sua logica, che nel Tramonto dell’euro e poi ancora

meglio in L’Italia può farcela viene spiegata: in un mondo nel quale il dollaro

subisce la pressione certo non dell’euro (una moneta senza stato può “premere”

solo sui propri cittadini), ma dello yuan, di fronte alla prospettiva di

perdere il proprio potere di signoraggio (stampo e compro), gli Stati Uniti

devono dotarsi di un’area di sbocco che serva loro per riequilibrare i propri

conti esteri. Oggi il dollaro lo vogliono ancora tutti. Quando ci sarà scelta,

non sarà più possibile per gli Stati Uniti indebitarsi indefinitamente in dollari.

L’Europa servirà quindi agli Stati Uniti esattamente allo stesso scopo al quale

il Sud Europa è servito alla Germania: un gigantesco outlet per collocare i

propri beni riequilibrando le proprie partite correnti, cioè il proprio

indebitamento netto estero. Inutile dire che il tentativo di destabilizzazione

della Russia si situa bene in questo quadro, per

i noti motivi. Nel Tramonto dell’euro evocavo l’ipotesi di una “alleanza”

fra paesi debitori (Usa e un pezzo di Europa) per contrastare Berlino. Questo

scenario “post-bellico” aveva e ha una sua razionalità, ma forse è ingenuo: gli

Stati Uniti possono anche permettersi di mangiarsi tutto il cucuzzaro, cioè il

creditore regionale (Germania) e i debitori regionali (fra cui noi), per

trasformarci in un simpatico panel di debitori loro. Lo scenario post-bellico

diventerebbe quindi quello di un’Europa finanziata dagli Stati Uniti per

acquistare beni di consumo statunitensi (via TTIP). In effetti, è già successo

col piano Marshall: cambio fisso, finanziamenti dagli USA, ecc. Ma nel secondo

dopoguerra il sangue dei cadaveri esigeva democrazia e stato sociale. Oggi non

ci sono ancora stati abbastanza morti perché capitale e lavoro addivengano a un

patto meno instabile. Perché, attenzione: la situazione è post-bellica, come ci

siamo più volte detti, sotto molti aspetti, ad esempio perché l’ammontare di

debiti (pubblici) accumulati è pari a quello raggiunto dopo la Seconda Guerra

Mondiale, ecc. Ma c’è un enorme MA! E l’enorme MA è che siccome oggi le

economie sono molto più aperte, la destabilizzazione indotta dal cambio fisso è

molto più rapida. Questo è il motivo per il quale il mondo sta andando, come

spiego nell’Italia può farcela, verso un frazionamento della sovranità

politica, e un’adozione

generalizzata della flessibilità del cambio: è la risposta razionale alla

destabilizzazione indotta dalla globalizzazione. E allora: gli Stati Uniti

possono permettersi di fare un boccone dell’Europa: il loro cavallo di Troia

sono i simpatici lobbisti di Bruxelles, quella manica di corrotti in conflitto

di interessi che chiamiamo “Commissione”. Ma possono permettersi di andare

contro la SStoria? Ecco, questo non lo so. Sicuramente oggi qualche consigliere

della Casa Bianca pensa che l’uscita dall’euro determinerebbe un frazionamento

e una conflittualità politica in Europa difficile da gestire per gli Usa (oltre

a rendere evidentemente impossibile la creazione dell’Eurollaro, il che

costituirebbe un ostacolo molto molto marginale, direi più che altro simbolico,

sulla strada del TTIP). D’altra parte gli statunitensi, a causa del loro